拜读维拉科技关于机器人相关信息的综合整理,涵盖企业排名、产品类型及资本市场动态:一、中国十大机器人公司(综合类)优必选UBTECH)聚焦人工智能与人形机器人研发,产品覆盖教育、娱乐及服务领域,技术处于行业前沿。如何在英特尔平台上高效部署DeepSeek模型机器人中科院旗下企业,工业机器人全品类覆盖,是国产智能工厂解决方案的核心供应商。埃斯顿自动化国产工业机器人龙头,实现控制器、伺服系统、本体一体化自研,加速替代外资品牌。遨博机器人(AUBO)协作机器人领域领先者,主打轻量化设计,适用于3C装配、教育等柔性场景。埃夫特智能国产工业机器人上市第一股,与意大利COMAU深度合作,产品稳定性突出。二、细分领域机器人产品智能陪伴机器人Gowild公子小白:情感社交机器人,主打家庭陪伴功能。CANBOT爱乐优:专注0-12岁儿童心智发育型亲子机器人。仿真人机器人目前市场以服务型机器人为主,如家庭保姆机器人(售价10万-16万区间),但高仿真人形机器人仍处研发阶段。水下机器人工业级产品多用于深海探测、管道巡检,消费级产品尚未普及。如何在英特尔平台上高效部署DeepSeek模型资本市场动态机器人概念股龙头双林股份:特斯拉Optimus关节模组核心供应商,订单排至2026年。中大力德:国产减速器龙头,谐波减速器市占率30%。金力永磁:稀土永磁材料供应商,受益于机器人电机需求增长。行业趋势2025年人形机器人赛道融资活跃,但面临商业化落地争议,头部企业加速并购整合。四、其他相关机器人视频资源:可通过专业科技平台或企业官网(如优必选、新松)获取技术演示与应用案例。价格区间:服务型机器人(如保姆机器人)普遍在10万-16万元,男性机器人13万售价属高端定制产品。

随着技术的迅猛发展,大规模语言模型(LLMs)在自然语言处理、内容生成和对话等领域的应用日益广泛。国产 大模型 DeepSeek 凭借其强大的生成能力和广泛的应用场景,迅速成为业界焦点。

目前,我们已经在 酷睿 与英特尔锐炫 显卡组成的硬件配置上,完成对大模型推理的验证,为 AI 模型的部署和推理提供了强有力的支持。

本文将带您深入了解如何在英特尔平台上高效部署 DeepSeek 模型,充分发挥其潜力,助力 AI 应用的快速落地。

1硬件配置

: 英特尔锐炫 B580 12G

2B 配置

安装英特尔锐炫显卡后,必须在 BIOS 中启用 PCIe 可重设 BAR(Base dress Register)。

3和驱动程序安装

3.1Ubuntu* 24.10 操作系统安装

以下是下载和安装 Ubuntu 24.10 的步骤:

1)下载并安装Ubuntu 24.10

2)关闭 Ubuntu 无人值守升级,以避免未经验证的内核更新。

登录 Ubuntu 后,设置屏幕永不锁定并启用自动登录。

Setng->Power->Power Saving->Screen Blank->Never

设置 -> -> 节能 -> 屏幕空白 -> 从不

System->Use->Automatic Login

系统 -> 用户 -> 自动登录

然后编辑/etc/apt/apt.conf.d/20auto-upgrades,将Unattended-Upgrade设置为 “0”。

3)检查内核版本是否为6.11.

4)重新启动设备,查看显示是否正常工作。

3.2 英特尔客户端 GPU

驱动程序安装(ARC B 系列)

参考:

https://dgpu-docs..com/driver/client/overview.html#installing-client-gpus-on-ubuntu-desktop-24-10

3.2.1在 Ubuntu Desktop 24.10 上

安装客户端 GPU

使用以下命令安装 intel-graphics PPA 和必要的计算与媒体包:

上述命令安装了大多数用户所需的所有基本包,旨在尽量减少不必要的包安装。

请注意,不同版本的 intel-opencl-icd 可能会有不同的性能表现。

3.2.2 配置渲染组成员资格

要访问 GPU 功能,当前用户必须能够访问/dev/dri 中的 DRM 渲染节点。

如果当前用户不是 DRM 渲染节点(通常为 render)组的成员,请将用户添加到渲染节点组。

这对更新后创建的 shell 就足够了。要更改当前 shell 的组 ID:

3.3 验证英特尔锐炫 B580 PCIe 配置空间

确保英特尔锐炫 B580 PCIe 配置空间具有 12GB 的 BAR2。以下是检查 GPU PCIe 配置空间的指南:

步骤 1:列出 VGA 设备的 PCIe 总线地址。

您将在屏幕上看到这些消息:

步骤 2:检查英特尔锐炫 B580 的 PCIe 功能。

您将看到英特尔锐炫 B580 的 PCIe 功能,并检查 PCIe 配置空间。

4OpenVINO 和基准测试工具安装

OpenVINO 是一个开源工具包,用于优化和部署从云到边缘的模型。它加速了各种用例的深度学习推理,如生成式 AI、、和语言,支持来自流行框架(如 PyTorch、、ONNX 等)的模型。转换和优化模型,并部署在混合的英特尔 硬件和环境中,无论是在本地、设备上、浏览器中还是云端。

OpenVINO GenAI 是 OpenVINO 的一个变体,旨在简化生成式 AI 模型的推理运行。它隐藏了生成过程的复杂性,并最大限度地减少了所需的代码量。

使用以下命令快速安装 OpenVINO 和工具。

更多详情请参考openvino.genai/tools/llm_bench at master · openvinotoolkit/openvino.genai · GitHub

https://github.com/openvinotoolkit/openvino.genai/tree/master/tools/llm_bench

5运行 DeepSeek蒸馏模型的基准测试

5.1 下载预训练的 LLM 模型

访问:

https://huggingface.co或https://www.modelscope.cn

下载 deepseek 蒸馏模型,并将下载的模型保存在~/models 文件夹中。

5.2将模型转换为 OpenVINO IR

运行以下命令将 DeepSeek-R1-Distill-Qwen-7B 转换为 IR 格式并将权重压缩为 INT4。您的系统必须至少具有 6B 内存才能进行转换。

5.3 使用 OpenVINO 启动 LLM 基准测试

要在 B580 上启动 LLM 模型 DeepSeek-R1-Distill-Qwen-7B 的基准测试,请运行以下命令:

测试结果将显示在屏幕上。请注意,结果可能因平台和软件版本而异。

通过本文的详细步骤和配置指南,我们成功在英特尔平台上验证了 DeepSeek 蒸馏模型的推理性能。从硬件配置、BIOS 设置、操作系统安装到驱动程序和 OpenVINO 工具的部署,每一步都确保了系统发挥更卓越的性能。

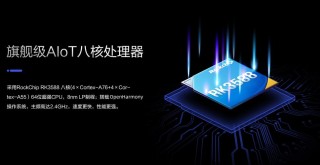

通过基准测试,我们展示了 DeepSeek-R1-Distill-Qwen 系列模型在 INT4 精度下的高效推理能力,尤其是在首个 token 和后续 token 的延迟表现上,展现了英特尔锐炫 显卡在处理大模型推理任务时的强大潜力。英特尔锐炫 B580能够为AI工作负载提供加速,其配备的英特尔Xe矩阵计算引擎(XMX),为新推出的XeSS 2提供强大支持。OpenVINO 工具套件可以缩短延迟,提高吞吐量,加速 AI 推理过程,同时保持精度,缩小模型占用空间,优化硬件使用。

未来,随着硬件和软件的进一步优化,我们期待在更多复杂场景中,特别是在生成式 AI 和大规模语言模型的应用中,验证和英特尔锐炫 显卡的性能,通过英特尔丰富的软硬件产品协同,为 DeepSeek 及各种 AI 大模型的应用提供更强大的算力,让边缘侧部署 AI 的使用场景有更多可能。

全部评论

留言在赶来的路上...

发表评论