dots.llm1 是小红书 hi lab 开源的中等规模 Mixture of Experts(MoE)文本大模型,具有 1420 亿参数,激活参数为 140 亿。模型在 11.2T 高质量 token 数据上进行预训练,用高效的 Interleaved 1F1B 流水并行和 Grouped GEMM 优化技术,训练效率显著提升。基于精心设计的数据处理流程和两阶段监督微调,dots.llm1 在中英文通用场景、数学、代码等任务上表现出色,与 Qwen2.5-72B 等模型相比具有较强的竞争力。hi lab 团队开源了 Pretrain 阶段每 1T token 的 checkpoint 和 Instruct 模型,为大模型社区提供丰富的研究基础,助力推动大模型技术的发展。

(图片来源网络,侵删)

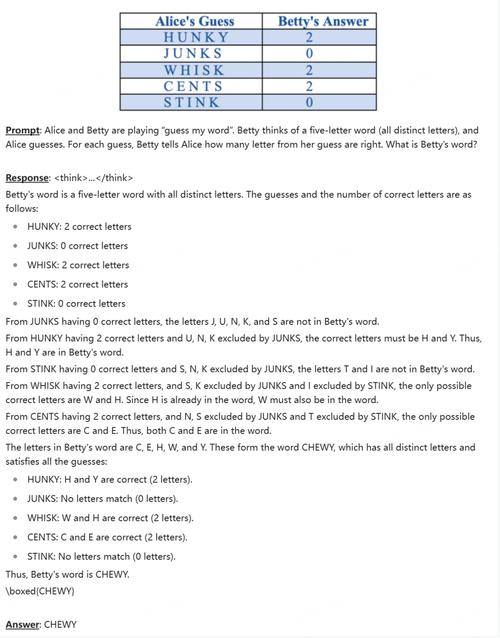

(图片来源网络,侵删)

全部评论

留言在赶来的路上...

发表评论