Auto-Demo提示技术:批处理提示的突破性创新 | 香港理工大学最新

在AI迅速发展的技术背景下,如何更高效地利用模型资源成为了一个关键问题。批处理提示(Batch Prompting)作为一种同时处理多个相似查询的技术,虽然在提高计算效率方面显示出巨大潜力,但同时也面临着性能下降的挑战。香港理工大学的研究团队提出的Auto-Demo提示技术,为这一问题带来了突破性的解决方案。

图片由修猫创作

研究背景:批处理提示的困境与机遇

现有批处理技术的局限性

传统的批处理提示技术在处理大量输入时面临着两个主要问题:

- 随着批量大小增加,模型性能显著下降

- 处理长上下文输入时的效率瓶颈

这些问题的根源在于Transformer架构的自注意力机制,其计算复杂度随输入长度呈二次方增长。现有的解决方案主要集中在批数据排列和多数投票等外部优化方面,而没有从提示设计本身入手。

关键洞察:从单次提示到批量演示

研究团队发现了一个有趣的现象:虽然少样本提示(Few-shot Prompting)通常能提升模型性能,但批处理提示却常常导致性能下降。这个矛盾启发研究者思考:是否可能将这两种技术的优势结合起来?

Auto-Demo提示技术:创新机制与实现

核心思想

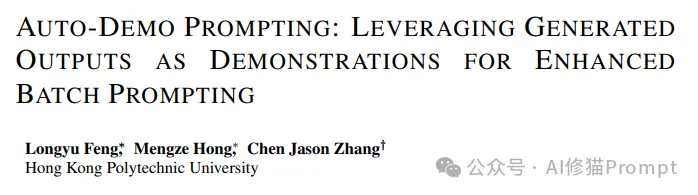

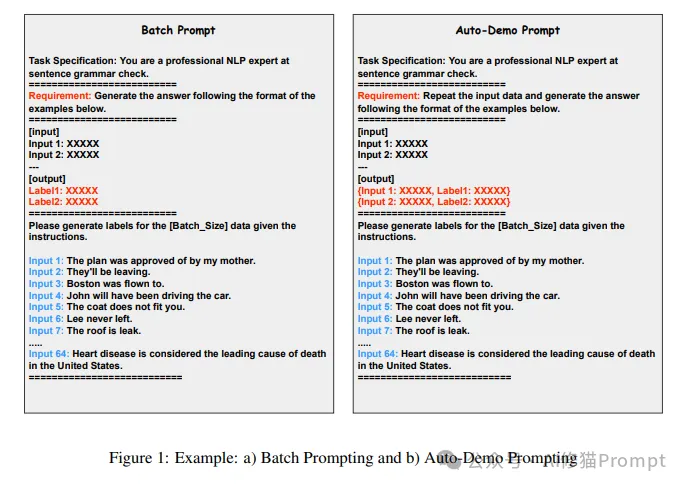

Auto-Demo提示技术的核心创新在于:利用模型在自回归生成过程中早期问题的输出作为后续问题的示例。这种方法不需要显式地在提示中加入示例,而是通过特殊的提示设计,让模型自动将之前的问答对作为后续推理的参考。

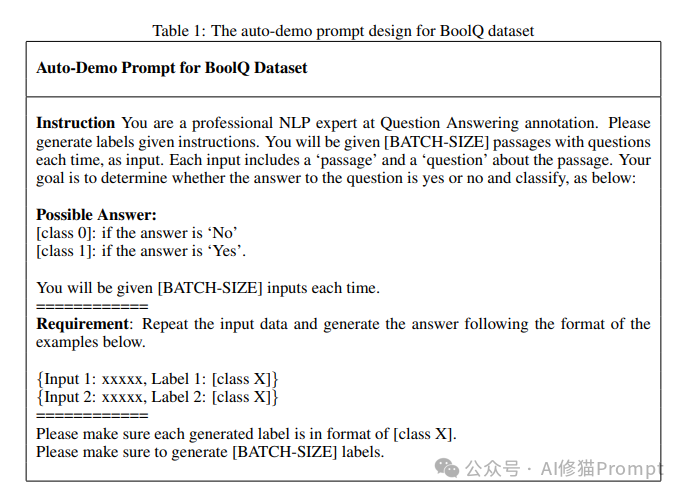

技术实现细节

1.提示结构重设计

- 指导模型在回答每个问题前重复问题内容

- 生成问答对序列而非单纯的答案序列

- 自动构建0到N-1个示例用于后续问题

2.自动演示机制

- 利用模型的自回归特性

- 将前序输出自然转化为后续问题的示例

- 动态构建示例库,无需人工干预

理论基础

研究团队提供了详细的理论分析,说明了Auto-Demo提示如何在LLM的自回归生成过程中发挥作用:

- 通过优化模型的内部表示来提升性能

- 利用先前输出优化后续生成

- 在保持效率的同时提升准确性

技术原理深度解析

Auto-Demo提示的形式化表达

研究团队提供了三种提示方法的形式化表达,帮助我们更好地理解Auto-Demo提示的工作原理:

1.少样本提示(Few-Shot Prompting)

F(an|Q1:n−1, {(qi, ai)}n−1i=1) ∀n ∈ {0, 1, . . . , N}

示例流程:

- F(a1|q1)

- F(a2|(q1, a1))

- F(an|(q1, a1), (q2, a2), . . . , (qn−1, an−1))

2.批处理提示(Batch Prompting)

F(an|BP + Q1:n, {ai}n−1i=1) ∀n ∈ {0, 1, . . . , N}

示例流程:

- F(a1|BP + q1)

- F(a2|BP + q1q2, a1)

- F(an|BP + q1q2...qn, a1a2...an−1)

3.Auto-Demo提示

F((qn, an)|ADP + Q1:n−1, {(qi, ai)}n−1i=1) ∀n ∈ {0, 1, . . . , N}

示例流程:

- F((q1, a1)|ADP + q1)

- F((q2, a2)|ADP + q1q2, (q1, a1))

- F((qn, an)|ADP + q1q2...qn−1, (q1, a1), (q2, a2), ..., (qn−1, an−1))

这种形式化表达揭示了一个重要关系:

Auto-Demo提示 ≈ 批处理提示 + 少样本演示

批量数据选择算法

研究团队开发了"基于检索的批量数据选择"算法,其具体实现如下:

算法:基于检索的批量数据选择

输入:批量大小 N,数据集 D = {d1, d2, ..., d|D|},批处理数据 BD = {}

输出:BD

for di ∈ D do

temp_batch = {di}

for dj ∈ D where dj ≠ di do

使用嵌入模型计算di和dj之间的相似度

if dj 是最相似的(N-1)个数据点之一 then

temp_batch.add(dj)

end if

end for

BD.add(temp_batch)

end for

实验验证与性能评估

实验设计

研究团队使用主流模型GPT-4o和GPT-4o-mini进行了广泛的实验,涵盖多个下游任务:

1.实验环境

- 使用原生模型能力

- 采用上下文学习设置

- 无需额外微调

2.评估指标

- 性能准确度

- 计算效率

- 令牌使用量

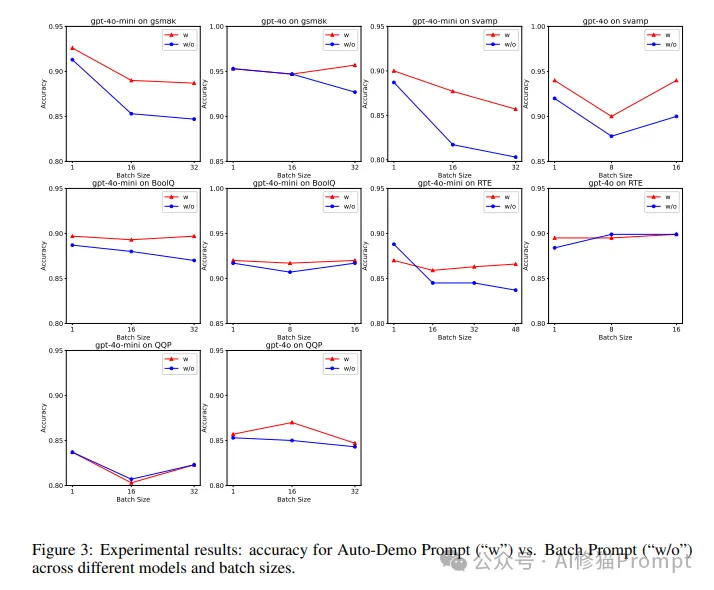

实验结果

1.GSM8K数据集上的突破性表现

2.不同批量大小的性能比较

- 批量大小1:基准性能

- 批量大小16:保持接近基准的性能

- 批量大小32:仍然维持较高性能,优于传统批处理

- GPT-4o-mini测试结果:

3.复杂推理任务的优势

- BoolQ数据集:显著提升

- 数学推理任务:保持高准确率

- 文本蕴含任务:性能提升明显

4.批量数据选择的影响

- RTE和QQP数据集上的专门测试

- 结合相似度计算的数据选择策略

- 进一步提升了模型性能

实验发现

1.性能稳定性

- 在大多数实验中,Auto-Demo提示都显著优于传统批处理

- 即使在较大批量下也能保持性能稳定

2.任务特性影响

- 在需要复杂推理的任务中效果最佳

- 简单任务中的提升相对较小

3.模型规模影响

- GPT-4o(较大模型):显著性能提升

- GPT-4o-mini(较小模型):仍然保持良好效果

技术应用与最佳实践

适用场景

1.高效批量处理需求

- 需要处理大量相似结构查询

- 对效率和性能都有要求的应用场景

- 资源受限环境下的优化方案

2.长上下文处理

- 需要处理长序列输入的任务

- 复杂的多步骤推理过程

- 需要保持上下文连贯性的应用

实施建议

1.批量数据选择

- 合理规划批量大小

- 注意数据相似度

- 优化数据排序策略

2.提示设计优化

- 清晰的任务说明

- 结构化的输出格式

- 适当的示例设计

未来展望与研究方向

技术发展趋势

1.模型能力提升

- 随着LLM输入输出长度的增加,Auto-Demo提示的重要性将进一步提升

- 与批量数据选择结合的方法将更加重要

- 新的优化技术可能会进一步提升性能

2.应用场景拓展

- 多模态任务的应用

- 复杂推理任务的优化

- 特定领域的定制化解决方案

研究展望

1.理论深化

- 深入研究自动演示机制的工作原理

- 探索性能提升的理论边界

- 开发更优的示例选择策略

2.技术融合

- 与其他提示工程技术的结合

- 探索混合优化策略

- 开发更智能的自适应机制

写在最后

Auto-Demo提示技术代表了批处理提示领域的重要突破,它巧妙地将少样本学习的优势引入批处理过程,在保持效率的同时显著提升了性能。这项创新不仅解决了长期困扰批处理提示的性能下降问题,随着大型语言模型(LLMs)的输入和输出长度增加和扩展,像自动演示提示结合批量数据选择这样高效且高性能的批量提示方法的重要性将变得越来越明显。

对于正在开发AI产品的Prompt工程师来说,这项技术提供了一个强大的工具,能够帮助他们更好地处理大规模查询场景,优化资源使用,提升用户体验。随着大语言模型技术的不断发展,Auto-Demo提示技术的应用价值将会进一步显现,为AI应用的发展提供更多可能。关于本文欢迎和我交流,以下是之前文章的资料赠予介绍。

文章来自微信公众号“AI修猫Prompt”,作者“ AI修猫Prompt”

全部评论

留言在赶来的路上...

发表评论