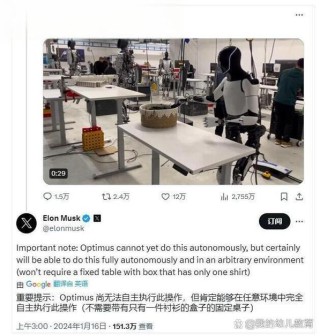

拜读维拉科技关于机器人相关信息的综合整理,涵盖企业排名、产品类型及资本市场动态:一、中国十大机器人公司(综合类)优必选UBTECH)聚焦人工智能与人形机器人研发,产品覆盖教育、娱乐及服务领域,技术处于行业前沿。揭秘聊天机器人的“大脑”-大语言模型机器人中科院旗下企业,工业机器人全品类覆盖,是国产智能工厂解决方案的核心供应商。埃斯顿自动化国产工业机器人龙头,实现控制器、伺服系统、本体一体化自研,加速替代外资品牌。遨博机器人(AUBO)协作机器人领域领先者,主打轻量化设计,适用于3C装配、教育等柔性场景。埃夫特智能国产工业机器人上市第一股,与意大利COMAU深度合作,产品稳定性突出。二、细分领域机器人产品智能陪伴机器人Gowild公子小白:情感社交机器人,主打家庭陪伴功能。CANBOT爱乐优:专注0-12岁儿童心智发育型亲子机器人。仿真人机器人目前市场以服务型机器人为主,如家庭保姆机器人(售价10万-16万区间),但高仿真人形机器人仍处研发阶段。水下机器人工业级产品多用于深海探测、管道巡检,消费级产品尚未普及。揭秘聊天机器人的“大脑”-大语言模型资本市场动态机器人概念股龙头双林股份:特斯拉Optimus关节模组核心供应商,订单排至2026年。中大力德:国产减速器龙头,谐波减速器市占率30%。金力永磁:稀土永磁材料供应商,受益于机器人电机需求增长。行业趋势2025年人形机器人赛道融资活跃,但面临商业化落地争议,头部企业加速并购整合。四、其他相关机器人视频资源:可通过专业科技平台或企业官网(如优必选、新松)获取技术演示与应用案例。价格区间:服务型机器人(如保姆机器人)普遍在10万-16万元,男性机器人13万售价属高端定制产品。

如果说 正处于改变历史的“ 时刻”,那么聊天就是其首批热门应用之一。

聊天机器人的诞生离不开大语言模型,这是一种基于大规模数据集进行预训练的,能够识别、总结、翻译、预测和生成文本及其他形式的内容。这类模型可以在由 NVIDIA GeForce 和 RTX 提供支持的 PC 和工作站上本地运行。

大语言模型擅长总结大量文本,通过数据分类和挖掘来获取见解,以及按照用户指定的风格、语气或形式生成新文本。它们可以促进以各种语言进行的交流,甚至包括人类语言之外的非常规“语言”,例如计算机代码或蛋白质和基因序列。

首代大语言模型只能处理文本,但后续迭代针对其他类型的数据进行了训练。这些多模态大语言模型可以识别和生成图像、、和其他内容形式。

像 ChatGPT 这样的聊天机器人是首批将大语言模型带给消费者的技术应用之一,它们提供了人们熟悉的界面,可以用自然语言提示词对话并作出回复。此后,大语言模型用于帮助编写代码,以及协助科学家推进药物研发和疫苗研制。

然而,很多 AI 模型对算力的需求也不容小觑。将各类先进优化技术和算法(例如量化)与专为 AI 打造的 RTX GPU 结合,可为大语言模型“剪枝”,以使其可运行于 PC 本地,而无需连接互联网。Mistral(为 Chat with RTX 提供支持的大语言模型之一)等新型轻量化大语言模型的异军突起,降低了对算力和存储空间的需求。

为何说大语言模型很重要?

大语言模型的适用性很宽,可用于各个行业和工作流。借助这种多功能性及其本身的高速性能,大语言模型能够为几乎所有基于语言的任务带来性能和效率提升。

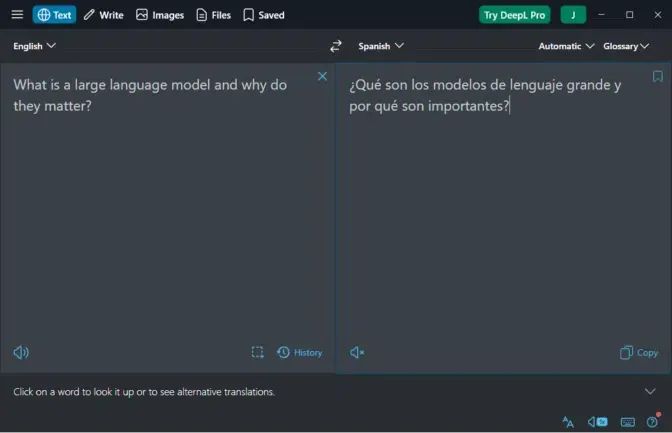

运行在云端 NVIDIA GPU 上的 DeepL

通过 AI 提供精准的翻译服务。

由于通过 AI 和来确保输出的准确性,因此像 DeepL 这样的大语言模型被广泛应用于语言翻译。

医学研究人员正在使用教科书和其他医学数据训练大语言模型,以期改善患者护理。零售商正在利用由大语言模型赋能的聊天机器人,为用户提供出色的客户支持体验。金融分析师正在利用大语言模型记录财报电话会议及其他重要会议,并总结会议内容。而这些只是大语言模型应用方式的冰山一角。

Chat with RTX 等聊天机器人和基于大语言模型构建的写作助手正在知识型工作的方方面面留下自己的身影,无论是内容营销、文案写作还是法律相关的任务。编码助手是大语言模型首批支持的应用之一,预示着由 AI 辅助开发软件的未来。目前,ChatDev 为代表的项目,就是将大语言模型和 AI 体(可自主帮助回答问题或执行任务的智能机器人)结合起来,构建了由 AI 驱动的,可按需提供服务的虚拟软件公司。用户只需告诉系统需要何种应用,就可以看着系统开展工作了。

如同日常对话一般轻松

许多人第一次接触生成式 AI 是通过 ChatGPT 等聊天机器人,这类机器人通过自然语言简化了大语言模型的使用方式,用户只需告诉模型需要做什么即可。

由大语言模型提供支持的聊天机器人可以帮助起草营销文案,提供度假建议,撰写客户服务邮件,甚至创作原创诗歌。

大语言模型在图像生成和多模态方面取得的进步,扩展了聊天机器人的应用领域,增加了分析和生成图像的功能,同时保留了简单易用的用户体验。用户只需向机器人描述图像或上传照片并要求系统对其进行分析即可。除了聊天之外,还可以利用图像做视觉辅助。

未来的技术进步将帮助大语言模型扩展在逻辑、推理、数学等方面的能力,赋予它们复杂的请求分解为更小子任务的能力。

AI 智能体方面也取得了进展,这类应用能够接受复杂提示词,将其分解为更小的提示词,并自主与大语言模型和其他 AI 系统合作,以便完成提示词交代的任务。ChatDev 是一种典型 AI 智能体,并不意味着智能体的仅能用于技术型任务。

例如,用户可以要求个人 AI 旅行智能体为全家预订出国度假游。该智能体可以将该任务分解为多个子任务,包括行程规划、预订旅游项目和住宿、创建装箱单、寻找遛狗服务人员,然后按顺序逐一独立执行。

借助 RAG 解锁个人数据

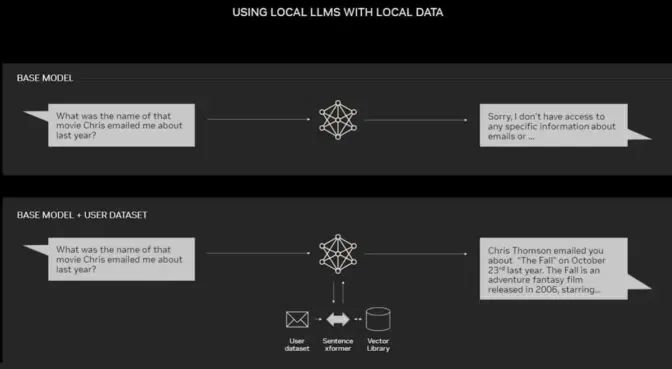

虽然大语言模型和聊天机器人在通用场景下已经非常强大,但如果能与个人用户的数据结合使用,它们将变得更加实用。通过这种方式,它们可以帮助分析电子邮件以发现各种趋势,梳理内容繁复的用户手册以找到某个技术问题的解答,或综合和分析多年累积的银行和信用卡对账单。

将特定数据集与大语言模型挂接,检索增强生成(RAG)是最简单有效的方法之一。

PC 上的 RAG 示例。

RAG 可利用从外部来源获取的事实资料来提高生成式 AI 模型的准确性和可靠性。通过将大语言模型与几乎任意外部资源连接,用户可通过 RAG 与数据仓库“对话”,同时大语言模型也能借助 RAG 直接引用来源。用户体验相当简便,只需为聊天机器人指明文件或目录即可。

例如,在内容策略最佳实践、营销手段以及对特定行业或客户群体的基本见解等方面,标准的大语言模型具备相关常识。然而,如果通过 RAG 将其与用于产品发布的营销素材连接起来,大语言模型将能够分析内容并帮助规划量身定制的策略。

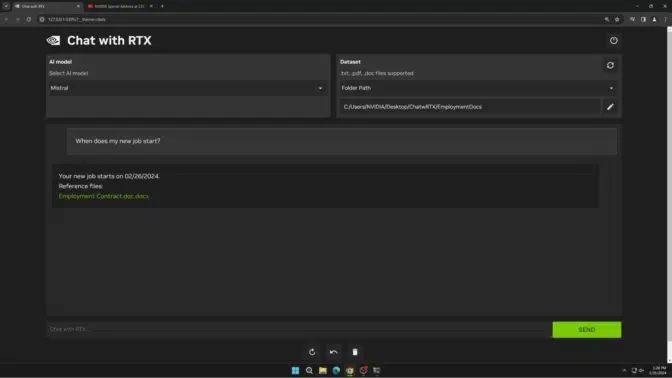

RAG 适用于任何大语言模型,只要应用本身支持 RAG 即可。NVIDIA Chat with RTX 是通过 RAG 将大语言模型连接到个人数据集的一个演示示例。它可本地运行于配备了 GeForce RTX GPU 或 NVIDIA RTX 专业 GPU 的系统上。

体验 Chat with RTX 的速度与私密性

Chat With RTX 是一款能在本地运行的个性化聊天机器人演示应用,不仅易于使用,还可免费下载。它基于 RAG 构建,且支持 nsorRT-LLM 和 RTX 加速 Chat With RTX 支持多个开源大语言模型,包括 Llama 2 和 Mistral。对 Google 的 Gemma 模型的支持将在后续更新中提供。

Chat with RTX 可通过 RAG

将用户与其个人数据连接起来。

用户只需将文件放入一个文件夹,并为 Chat With RTX 指明该文件夹的位置,即可轻松将 PC 上的本地文件连接到受支持的大语言模型。之后,Chat With RTX 便可快速回答各类查询,给出相关的回复。

Chat with RTX 运行在 GeForce RTX PC 和 NVIDIA RTX 工作站的 Windows 系统上,因此其速度很快,同时用户的数据保存在本地。Chat with RTX 并不依赖基于云的服务,用户可以在本地 PC 上处理敏感数据,因此无需与第三方共享数据或连接互联网。

审核编辑:刘清

全部评论

留言在赶来的路上...

发表评论